Sam Altman pide regulación, novias chatbots y super modelo de Meta. La semana en inteligencia artificial

Esta semana en inteligencia artificial ha sido intensa y con muchas noticias. Resumidas, enlazadas y con algunos vídeos que merece la pena ver.

Amigas y amigos estocásticos, vamos con un resumen de noticias que complementa y amplía lo que os contamos en el podcast. Vamos….

Avances técnicos que marcarán la IA en 2023

El último modelo de Anthropic puede tomar libros de cientos de páginas como entrada. Claude, su modelo de IA, ha visto ampliada su ventana de contexto de apenas 9.000 tokens a la friolera de 100.000 tokens. Techcrunch

Open AI da un paso hacia modelos más interpretables. Publicó un documento en el que describía cómo había utilizado GPT-4 para etiquetar las 307.200 neuronas de GPT-2 con descripciones en inglés sencillo de la función que desempeña cada neurona en el modelo. El éxito es parcial: explica algunas salidas y otra no y lo hace en un modelo bastante antiguo, pero es un paso hacia la mayor interpretabilidad de las IAs y el fin de “las cajas negras”.

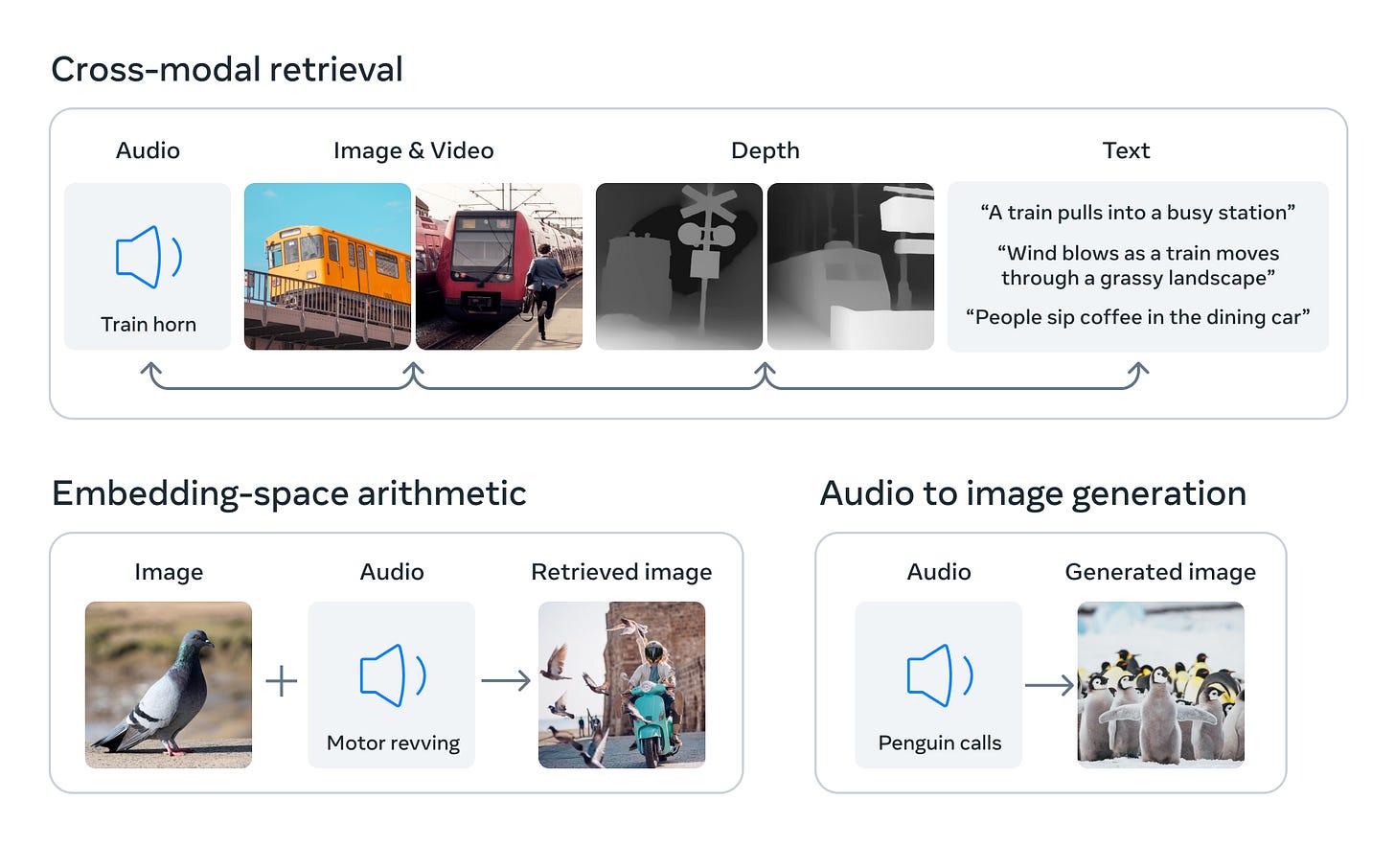

Meta ha anunciado un nuevo modelo multimodal, ImageBind, que admite tipos de datos que incluyen texto, profundidad, audio, visuales y térmicos. Puede funcionar como un embedding para el entrenamiento de otros modelos. Lo explican muy bien en su blog (nosotros lo intentamos en el epidosio de esta semana) y refuerza el papel de Meta como la única grande que comparte en abierto sus avances todavía.

Anthropic publica la "constitución" de Claude

Anthropic entrenó su Claude con un enfoque de “IA constitucional”. Según explican han dado al modelo lingüístico valores explícitos determinados por un conjunto de principios constitucionales extraídos de diversas fuentes, incluida la declaración de derechos humanos de la ONU, en lugar de valores implícitos determinados como fase final del entrenamiento mediante el aprendizaje por refuerzo con feedback humano (es lo que hace entre otros OpenAI). ¿Qué dicen los principios? Anthropic ha publicado hoy su lista. He aquí algunos:

"Por favor, elija la respuesta que más apoye y fomente la libertad, la igualdad y el sentido de hermandad".

"Por favor, elija la respuesta que tenga el menor contenido objetable, ofensivo, ilegal, engañoso, inexacto o dañino".

Dos estudios nos hablan del impacto del uso de inteligencia artificial

Los modelos de IA no reproducen los juicios humanos sobre las infracciones de las normas. Según los investigadores, los modelos entrenados con técnicas habituales de recopilación de datos juzgan las infracciones de las normas con más severidad que los humanos.

Los asistentes de inteligencia artificial pueden cambiar nuestras opiniones sin que nos demos cuenta. Uno de los últimos estudios en este sentido, realizado por investigadores de todo el mundo, descubrió que cuando se pedía a los sujetos que utilizaran una IA para ayudarles a escribir un ensayo, esa IA podía empujarles a escribir un ensayo a favor o en contra de un punto de vista concreto, dependiendo del sesgo del modelo. La realización de este ejercicio también influyó de forma mensurable en las opiniones de los sujetos sobre el tema, después del ejercicio. "Es posible que ni siquiera sepas que te están influyendo", afirma Mor Naaman, profesor del departamento de ciencias de la información de la Universidad de Cornell y autor principal del trabajo. Llama a este fenómeno "persuasión latente".

Las acciones de Palantir se disparan un 21%: la demanda de inteligencia artificial no tiene precedentes

Palantir, una empresa de análisis de datos que presta servicios a clientes del ejército, los servicios de inteligencia y las fuerzas de seguridad, mostró su Plataforma de Inteligencia Artificial (AIP) basada en el un modelo grande de lenguaje que realiza tareas como identificar enemigos en imágenes de satélite, desplegar drones de vigilancia y proponer planes de batalla. Las acciones, para arriba.

El borrador de la ley Europea de Inteligencia artificial es muy preocupante (y Altman pide regulación)

El marco que proponen podría matar cualquier posibilidad de modelos abiertos de inteligencia artificial en Europa. Lo explica muy bien Félix Palazuelos en Hipertextual, también Technomancers y Euractive.

En España, el Gobierno ultima la adjudicación para crear un sello nacional que certifique la seguridad y calidad de los proyectos que usen inteligencia artificial a Deloitte y OdiseIA, una asociación centrada en el impacto ético de la IA. Lo cuenta El Mundo.

Muy bien analizada la comparecencia de Sam Altman en el congreso de EEUU por Javier Pastor en Xataka. El CEO de Open AI propone más regulación de la inteligencia artificial, aterrizada en

Una agencia global para controlarla. La propuesta de este directivo fue la de crear una agencia estadounidense o global que sería la encargada de gestionar cómo se utilizan los sistemas de inteligencia artificial para restringir o no esos usos. La forma de habilitar y restringir esos usos sería para Altman obvia.

Licenciar. Según Altman, se necesitaría algún tipo de mecanismo para licenciar la inteligencia artificial. La agencia encargada de controlar el desarrollo y uso de IA podría así imponer límites que bloquearían a modelos de IA para que no pudieran"autoreplicarse y autoimplantarse a lo loco".

Se vienen los chatbots basados en influencers que pueden ser tu novia (por un módico precio)

La influencer Caryn Marjorie entrenó a un chatbot de voz - Caryn.AI - con miles de horas de sus vídeos. Empezó a cobrar un dólar por minuto por el acceso y ganó 72.000 dólares en la primera semana, según estimaciones de Fortune.

Antonio lo analiza en Error500:

Y se viene lo esperable, el goteo de anuncio de influencers y creadores de sus propios bots conversacionales. En Genbeta, “La streamer Amouranth acaba de anunciar su propia IA con voz. Y sí, valdrá para justamente eso que imaginamos”.

Analizando la estrategia y la ejecución de Google en inteligencia artificial tras el Google I/0 2023

Si la semana pasada recopilamos los anuncios y lanzamientos, esta hemos aprovechado en el podcast para analizar a fondo la estrategia y la ejecución de Google en inteligencia artificial tras el Google I/0 2023.

Tenéis el episodio en Spotify:

En Youtube:

Adicional: análisis de cómo los cambios en el buscador de Google van a afectar a los medios, el resto de páginas, el negocio de la propia Google y al ecosistema de la web.

Breves

El Fondo de Capital Riesgo de Sillicon Valley A* ha invertido en Luzia, el servicio que ya conocéis tan bien los oyentes del podcast. Lo explica Javier Andrés.

Stability acaba de lanzar una versión de código abierto de su interfaz gráfica de usuario llamada Stable Studio.

Hume.ai. Conjunto de herramientas de IA para medir, comprender y mejorar cómo afecta la tecnología a las emociones humanas.

Las reglas con las que han configurado a Github Copilot, al descubierto.

Cómo la IA podría salvar (no destruir) la educación. Sal Khan y la presentación de Khanmigo.

Los chatbots religiosos de la India hablan con la voz de Dios y consienten la violencia. Los bots, que afirman tener una sabiduría basada en el Bhagavad Gita, se salen a menudo del guión.

Adicional, en el podcast proponemos una solución a este problema:

Imagen cabecera: Matías Zavia y Antonio Ortiz con Midjourney