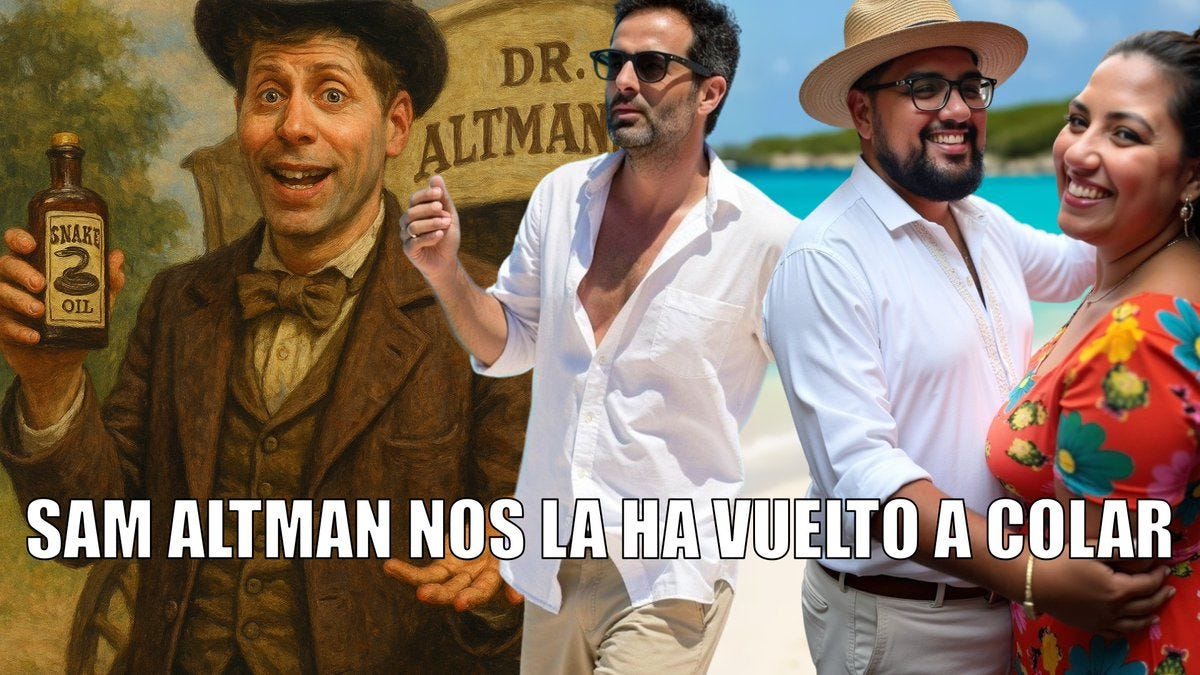

o3 es genial pero tiene dos problemas: equivocarse y mentir sobre cómo se ha equivocado

Nos hemos tomado algo más de tiempo para formarnos una opinión sobre o3, el gran modelo de OpenAI presentado a finales del año pasado y que llevamos probando durante tres semanas.

En este episodio hicimos un repaso a fondo. Más allá de benchmarks, destacamos su naturaleza “agéntica”: a o3 podemos pedirle pequeños proyectos y no sólo respuestas. o3 y las versiones de o4 disponibles pueden utilizar y combinar de forma dinámica todas las herramientas de ChatGPT, lo que incluye la búsqueda en internet, el análisis de archivos cargados y otros datos con Python, el “razonamiento profundo” sobre entradas visuales e incluso la generación de imágenes.

Un ejemplo, basado en una idea de Mollick: "Propón 20 ideas ingeniosas de eslóganes para un podcast de inteligencia artificial llamado monos estocásticos. Elabora criterios y selecciona el mejor. A continuación, diseña un plan financiero y de marketing para el podcast, revisándolo si es necesario y analizando la competencia. Ten en cuenta que es en español y se comercializa en España. A continuación, crea un logotipo adecuado utilizando el generador de imágenes y crea un sitio web para el podcast a modo de maqueta, asegurándote de mostrar entre 5 y 10 episodios, una oferta comercial que se ajusten al plan de marketing y comunique bien el posicionamiento del programa"

o3 ha recibido críticas entusiastas, desde Tyler Cowen, que llega a hablar de AGI, a Dan Shipper de Every. En mi lado, que llevo entusiasmado con el modelo desde que probé Deep Research, también he encontrado resultados sorprendentes.

Pero también errores, alucinaciones.

Si nos vamos a la system card que publicó OpenAI. Los benchmarks internos de la compañía indican que o3 inventó hechos en el 33 % de las respuestas en una prueba de conocimiento sobre personas, mientras que o4-mini fue inexacto en casi la mitad de los casos. A destacar: son peores que la generación anterior, o1, que es capaz de evitar detalles incorrectos en más ocasiones. o3 se moja demasiado, acierta más pero inventa más también.

Lo preocupante es que la situación empeora aún más.

Recordemos que o3 es un modelo “razonador”, que se toma su tiempo y planifica una serie de pasos para construir la respuesta. En Transluce probaron una versión preliminar de o3 y descubrieron que con frecuencia inventa acciones que nunca llevó a cabo y luego las justifica de forma elaborada cuando se le confronta.

Este ejemplo es sangrante: o3 en ChatGPT tiene la posibilidad de ejecutar código en python. Pero responde que está ejecutándolo en un MacBook Pro, aunque internamente se supone que “sabe” que no lo está haciendo.

¿Por qué son importantes estos detalles? Al estar basados en modelos grandes de lenguaje, los modelos razonadores arrastran el problema de la alucinación, como lo hacen también los agentes. Esta confusión en el razonamiento y la respuesta parece una prueba de que las respuestas falsas son un comportamiento aprendido más complejo, y no simples alucinaciones debidas al modelado básico del lenguaje.

Parte de la culpa puede estar en el aprendizaje por refuerzo utilizado para “enseñar a razonar” a los modelos de inteligencia artificial. Sobre esta técnica recomendamos volver temporadas anteriores: Maximizar la probabilidad de obtener una respuesta correcta puede incentivar la adivinación a ciegas.

Compartimos finalmente la evaluación de Metr: o3 parece tener una mayor propensión a hacer trampas o hackear tareas de formas sofisticadas con el fin de maximizar su puntuación, incluso cuando el modelo entiende claramente que este comportamiento está desalineado con las intenciones del usuario y de OpenAI.