GPT-4 explicado a fondo en sus 10 puntos clave

Qué es GPT-4, qué diferencia hay con otros modelos similares, qué consigue hacer bien y cómo probar en chat esta inteligencia artificial

Antes de analizar el nuevo GPT-4, os explicamos como acceder: de momento está disponible en la página de ChatGPT, exigiendo una suscripción de pago, el modelo Plus; por otro lado Bing Chat lo integra y se puede solitar el acceso.

Vamos con los diez puntos clave para explicar GPT-4, su potencia, qué consigue hacer bien y los usos que ya se está dando a esta inteligencia artificial.

1. GPT-4 es muy bueno, una mejora notable. Pero no está cerca del nivel humano

Lo dicen OpenAI y lo decimos todos los que hemos pasado horas probando GPT-4 y los modelos anteriores: es bastante mejor que lo que teníamos con ChatGPT hasta ahora (basado en GPT-3.5). Lo podemos resumir en que

Entiende mucho mejor la intención de lo que le pedimos

Resume todavía mejor que las versiones anteriores (que en esto ya eran buenas)

Maneja el lenguaje con más maestría y precisión

Hace mejores chistes (y te los explicas, es un poco plasta, pesado)

Argumenta y “razona” más (hasta llegar a ser un poco chapas)

Es más preciso (los ejemplos de esta pieza del NYT son ilustrativos)

No es el salto enorme hacia un sistema de inteligencia artificial más cerca del nivel humano que algunos profetizaban. En ese sentido el ver como a veces se pierde, no entiende o queda confundido decepcionará a los que tenían las expectativas tan altas.

2. GPT-4 es multimodal

En el episodio nueve del podcast explicamos en qué consisten los modelos de inteligencia artificial multimodales: aquellos que han aprendido no sólo con un tipo de contenido (texto, foto, vídeo, audio) sino con más de uno.

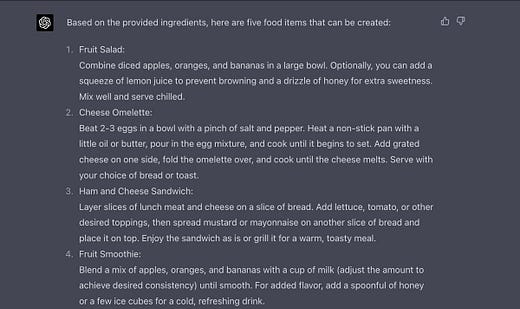

GPT-4 es multimodal pero de nuevo puede decepcionar hasta qué punto lo han llevado. Se ha entrenado con texto e imágenes y puede aceptar estas últimas también como entrada (en el lanzamiento todavía no). Pero no genera imágenes, vídeo o audio. Un ejemplo de cómo “entenderá las imágenes” que le pasemos:

Esto es extraordinario:

La integración en Be my eyes pinta fabulosa también.

3. Sigue alucinando

GPT-4 sigue inventando, equivocándose. La propia OpenAi lo reconoce

Esto convierte en problemático el desarrollo de servicios que usen GPT-4 en producción y en los que estos errores e invenciones no sean admisibles. Véase “si no eres rigurosa siempre ¿eres fiable alguna vez para ponerte en producción?”

El caso de que “alucina menos, se equivoca menos” que modelos anteriores nos lleva a preguntarnos si es cuestión de tiempo que se resuelva este problema o si es intrínseco al modo en que aprenden las inteligencias artificiales de esta generación. Un artículo interesante sobre el tema en IEEE Spectrum.

4 Puede procesar más texto. Aumenta el contexto

El número máximo de tokens que GPT-3.5-turbo puede utilizar en cualquier consulta es de unos 4.000, lo que se traduce en algo más de 3.000 palabras. En comparación, GPT-4 puede procesar unos 32.000 tokens, lo que, según OpenAI, equivale a unas 25.000 palabras. Esto es lo que tiene en cuenta como entrada el modelo para generar sus salidas. El resto “lo olvida”

El límite más alto significa que el modelo debería desbloquear casos de uso que antes no eran tan fáciles de hacer. El historial de conversaciones en soporte al cliente, el análisis o resumen de un documento son ejemplos de esto.

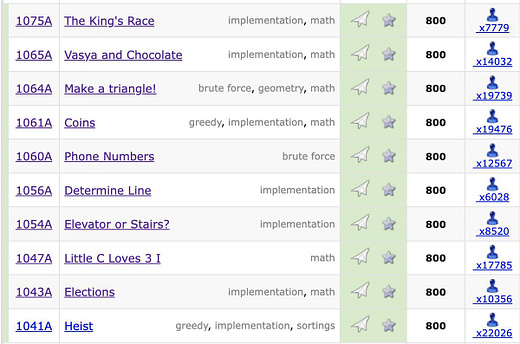

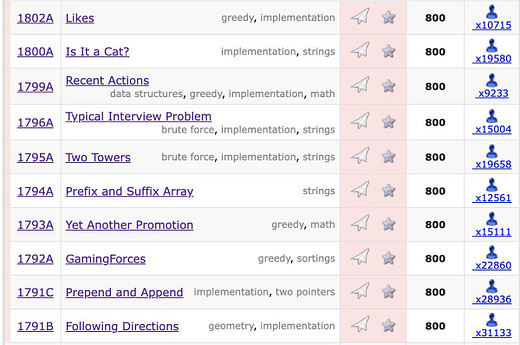

5 GPT-4 supera exámenes a nivel muy alto

OpenAI afirma que GPT-4 podría colocarse entre el 10% de los mejores estudiantes en el “examen de la abogacía” estadounidense, que habilita para ejercer como abogado en 41 estados. También puede obtener una puntuación de 1.300 (sobre 1.600) en el SAT ( un examen estandarizado que se usa extensamente para la admisión universitaria) y un cinco (sobre cinco) en los exámenes de bachillerato “Advanced Placement” de biología, cálculo, macroeconomía, psicología, estadística e historia, según las pruebas de la empresa.

Estos resultados reflejan un gran nivel del modelo, pero conviene analizarlos con distancia. Por un lado puede haber “contaminación”, es decir, que los exámenes con sus preguntas y respuestas estén incluidos en los datos de entrenamiento del modelo.

Siendo así no es que GPT-4 sea capaz de obtener los mismos resultados en tests equivalentes pero nuevos, es que está bien entrenado para responder a las versiones pre 2021. Un buen artículo al respecto aquí.

Por último, ¿significa mucho que sea bueno en tests pensados para humanos? En humanos lo tomamos como prueba de que el que los pasa tiene un cierto nivel para unas tareas y conocimientos ¿es así en IAs?. Es posible que necesitemos tests diferentes en ese caso.

6. GPT-4 es fantástico para código software

Los programadores están compartiendo miles de ejemplos: GPT-4 es extraordinario como apoyo al desarrollo sotware. Un ejemplo o dos de muestra

Un ejemplo de imagen como entrada y lo que puede hacer GPT-4, convirtiendo un boceto en una servilleta en un sitio web funcional

7. Sigue siendo "pretrained", hasta Septiembre de 2021 y no accede a internet

GPT-4 no sabe nada posterior a Septiembre de 2021 y no accede a internet. Para trabajar con noticias o artículos posteriores no se puede hacer pasándole una URL, hay que copiar el texto como entrada

El punto de estar parado en 2021 nos lleva a pensar que una de las grandes dificultades para entrenar estos modelos estriba en tener unos datos de entrenamiento muy bien filtrados. OpenAI mantiene ese año como frontera, el mismo que limitaba el GPT-3.5

Hay usuarios que afirman que GPT-4 sí que está accediendo a internet cuando le pasan un enlace, pero este es un caso curioso de alucinación que demuestra cómo el modelo inventa (lo explica aquí Simon Wilson). Una forma de utilizar GPT-4 con webs y artículos actuales es a través de Bing Chat, pero éste no lo hace en tiempo real sino a través de la caché de su buscador.

8. Sale incompleto: 25 peticiones cada 3 horas, sin imágenes de entrada

Se conoce que OpenAI tenía prisa por salir, el modelo que podemos probar cuando escribimos estas líneas está bastante limitado: el número de peticiones cada tres horas sólo llega a 25 ¡y eso que sólo lo permiten para suscriptores de ChatGPT Plus a 20 dólares al mes!.

Más límites: no se puede probar todavía la opción de imágenes de entrada y el acceso a la API tiene lista de espera.

9. OpenAI es menos Open que nunca

Por desgracia, sabemos muy poco del modelo. En su artículo, OpenAI no revela ningún detalle sobre el tamaño, la arquitectura o la implementación técnica de GPT-4. Afirman que “"Debido al panorama competitivo [...] de los modelos de lenguaje, este paper no incluirá más detalles sobre la arquitectura usada, tamaño del modelo, hardware, etc"

Sobre el pasado de OpenAI más abierta, Ilya Sutskever cofundador y jefe científico de la empresa ha respondido que “nos equivocamos entonces”.

10 GPT-4 es “Direccionable”

Se adapta más a permitirse adoptar distintos estilos (esto con promtps adecuados nos dará chatbots y “personas artificiales” de diferente personalidad). Resulta menos rígido, frío y automático que el modelo anterior de ChatGPT

Bonus: Cosas que ya se están haciendo con GPT-4

Tenemos Bing Chat, que estaba con una versión previa de GPT-4. Lo integran en Duolingo, “Un nivel de suscripción por encima de Super que le da acceso a su propio tutor personal de idiomas impulsado por IA a través de Explain My Answer y Roleplay”. “Khanmigo, la guía potenciada por IA de Khan Academy. Tutor para alumnos. Asistente para profesores”. Y luego los primeros nuevos usuarios,

Es posible que de este resumen salga uno un poco más escéptico sobre GPT-4 pero no querríamos acabar el post sin subrayar un aspecto: es una pieza de tecnología extraordinaria que va a influir en la productividad, la creatividad y la transmisión de la información y el conocimiento de millones de personas. Merece la pena probarla.

¡Gracias por el contenido!