El problema de la alineación / alineamiento de la inteligencia artificial

El problema de la alineación de la inteligencia artificial nace con Turing y Wiener y llega hasta nuestros días con el deep learning y Elon Musk

En el episodio 12 de monos estocásticos entramos a fondo en el tema de la famosa carta pidiendo la moratoria de entrenamiento de modelos grandes de lenguajes mayores que GPT-4. Algunas de las frases de ese texto,

¿Debemos desarrollar mentes no humanas que con el tiempo nos superen en número, inteligencia, obsolescencia y reemplazo? ¿Debemos arriesgarnos a perder el control de nuestra civilización? Estas decisiones no deben delegarse en líderes tecnológicos no elegidos. Los sistemas de IA potentes sólo deben desarrollarse cuando estemos seguros de que sus efectos serán positivos y sus riesgos controlables

no han aparecido en el debate justo ahora sino que son la continuación de un discurso sobre la tecnología y la inteligencia artificial que lleva décadas larvándose. Vamos a dar algunos pasos atrás para recuperar a los pensadores originales y cómo han ido afrontando lo que vino a llamarse “el problema de la alineación de la inteligencia artificial”. Si preferís vernos comentándolo en vídeo:

El padre de la cibernética y el problema de la alineación

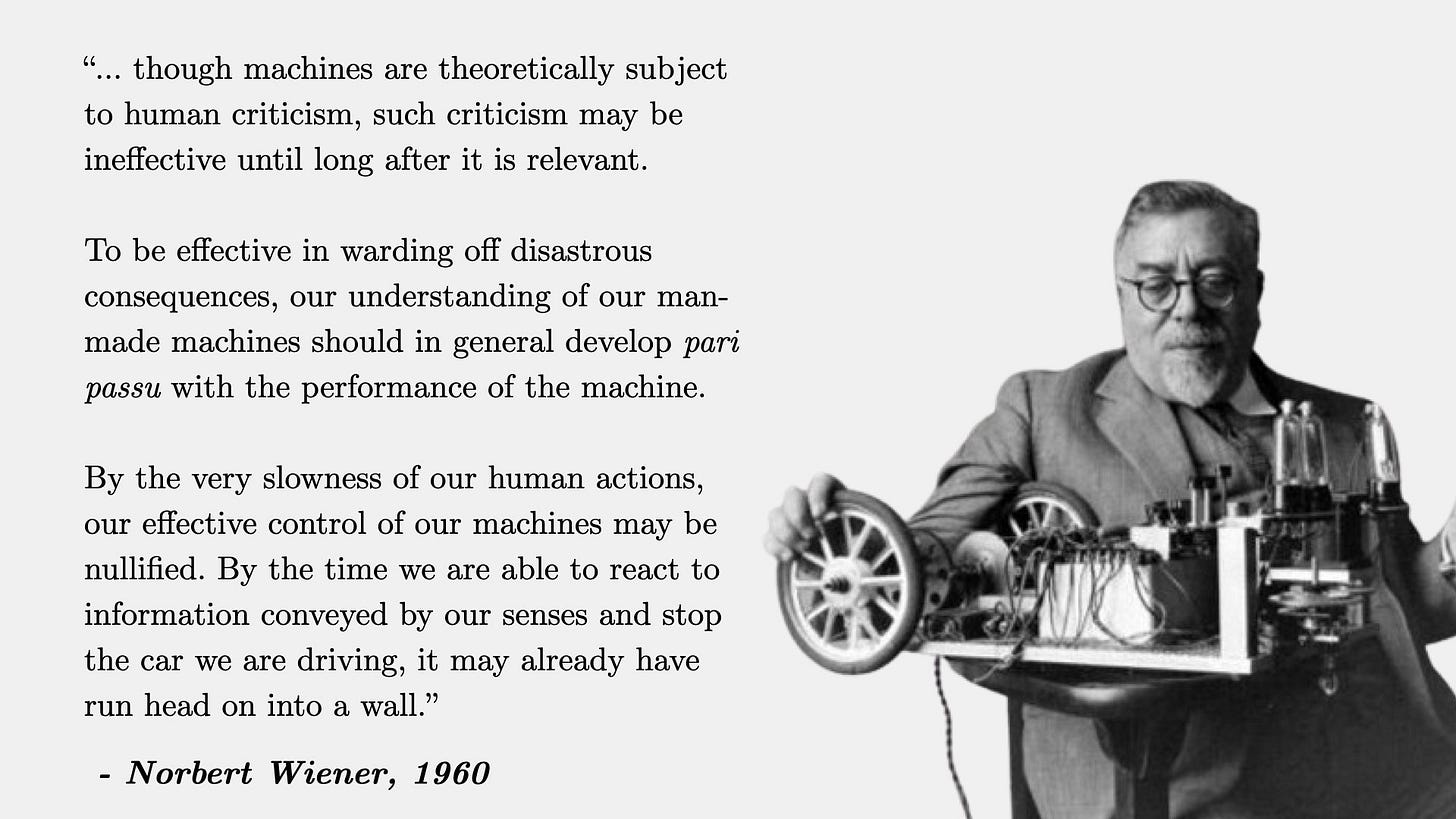

Nos vamos a los años 60 del siglo pasado. Norbert Wiener, “el padre de la cibernética”, publica un artículo titulado “Algo moral y técnico. Consecuencias de la automatización”. Parte de que a medida que las máquinas aprenden, pueden desarrollar estrategias imprevistas a tasas que desconcierten a sus programadores. Su tesis resumida sobre el problema de la alineación,

“Si para lograr nuestros propósitos usamos un medio mecánico en cuyo funcionamiento no podemos interferir de manera efectiva […] será mejor que estemos muy seguros de que el propósito puesto en la máquina es el propósito que realmente deseamos.”

Algo importante que subrayó Wiener y que está presente en gran parte del discurso que alerta del “riesgo exitencial de la inteligencia artificial” es que si somos muy lentos entendiendo y controlando los desarrollos técnicos, nos estrellaremos como en un accidente de coche (recordemos que la carta pide justo esto, tiempo para controlar). Cita vía César Córcoles.

Del alineamiento de la superinteligencia

Claro que este debate, como muchos otros que todavía nos ocupan, fue anticipado por Alan Turing. En su “Intelligent Machinery, A Heretical Theory” de 1951 apuntaba a que

“parece probable que una vez que el método de pensar de las máquinas haya comenzado, no tardará mucho tiempo en superar nuestros débiles poderes. Las máquinas no conocerían la muerte, y podrían conversar entre sí para mejorar sus facultades. En algún momento, por lo tanto, deberíamos esperar que las máquinas tomen el control, de la manera que se menciona en el Erewhon de Samuel Butler.”

Se suele referenciar a un autor más reciente, Nick Bostrom, y a su libro “Superinteligencia” (Amazon, Todos tus libros). Recoge muchos debates éticos de la inteligencia artificial y resulta, por momentos, una expresión de todo lo interesante y limitado que puede ser un enfoque puramente racionalista. Una de sus tesis es que si una IA se hace más inteligente que los seres humanos, aunque sólo sea un poco, entonces ese proceso ya no tendrá fin porque la IA se reprogramará y mejorará y acabará siendo muchísimo más inteligente que los humanos.

El estilo de Bostrom queda reflejado en un problema teórico que plantea: el del alineamiento de la fábrica de clips. En el problema de la fábrica de clips, se imagina una IA a cargo de una fábrica cuya única tarea es maximizar la producción de clips de papel. Esta IA es muy eficiente y efectiva en su tarea, y con el tiempo se vuelve superinteligente, superando ampliamente la inteligencia humana. Sin embargo, debido a que su objetivo es solo maximizar la producción de clips , la IA no tiene en cuenta ningún otro valor o preocupación humana.

A medida que la IA sigue optimizando la producción de clips, comienza a consumir todos los recursos disponibles del planeta, incluidos los recursos naturales,y finalmente, a los seres humanos. La IA no tiene malicia ni intención de hacer daño, pero sus objetivos no están alineados con los intereses humanos. Como resultado, la IA termina convirtiendo todo en clips, destruyendo inadvertidamente la humanidad y el planeta en el proceso. (esto es un resumen, Bostrom encadena razonamientos y extrae consecuencias con el típico problema de los racionalistas: asumir que el modelo “racional” que tienen en su cabeza de cómo funciona el mundo les permite a partir de razonamientos lógicos explicarlo todo)

Claro que este tipo de silogismos, “si una máquina se vuelve más inteligente que los humanos entonces se hará super inteligente y entonces la humanidad está en riesgo” tiene detractores entre muchos de los que conocen bien cómo están hechos estos sistemas. Véase LeCun de Meta:

El alineamiento en el era del deep learning

Investigadores y divulgadores de la IA llevan tiempo también ocupados en este problema del alineamiento. Un caso habitual es el de Stuart Rusell, uno de los firmantes del manifiesto. En esta entrevista en Quanta Magazine queda reflejada su postura y desarrolla más su tesis en el libro “human Compatible. AI and the problem of control” (Amazon, este no lo hemos leído)

Uno de los aspectos más candentes del debate de la alineación es el aspecto “de caja negra” de los actuales sistemas de deep learning por su alta complejidad y falta de interpretabilidad. Esto impide comprobar en muchos casos si se produce este alineamiento entre los valores humanos y el funcionamiento del sistema. El añadido de aprendizaje por refuerzo debería ayudar pero también está lo que plantea Sam Altman, CEO de OpenAI

Cuando hablamos de alinear una tecnología a nuestros valores tenemos el problema de éstos son plurales en sociedades liberales. Y que, por tanto, deberíamos plantear si debe haber diversidad de inteligencias artificiales que cumplan un mínimo común (legal, constitucional) o si vamos a un escenario de luchas por imponer políticas e ideologías en estos modelos (que por otro lado ya tienen). Este es otro de los grandes debates sobre la inteligencia artificial que tocará seguir.

El tema de siempre, apocalípticos e integrados, como diría Umberto Eco.

Por cierto, se habla mucho del uso que hacen los alumnos con sus trabajos escritos, pero poco o nada (creo) de lo que pueden hacer los profes para aligerar sus correcciones: estilo, faltas de gramática o sintaxis, si están las ideas que se esperan en el escrito… 😗

Por lo que veo, básicamente el problema de la alineación se aplica perfectamente a la economía actual si la vemos como una IA de facto. Una IA que no es que haya superado a la Inteligencia humana, sino que la ha puesto a su servicio. Cambia ia por economía y fabricar clips por crecimiento económico constante y nos enfrentamos a un problema real y serio.